OpenAI regresa a sus raíces de código abierto y lanza modelos de IA de 120B y 20B

En un cambio importante, OpenAI finalmente ha lanzado dos modelos de IA de pesos abiertos llamados gpt-oss-120b y gpt-oss-20b, desde el lanzamiento de GPT-2 en 2019. OpenAI afirma que sus nuevos modelos de IA de pesos abiertos ofrecen un rendimiento de vanguardia en el ámbito del código abierto, superando a modelos de tamaño similar. Ambos son modelos de razonamiento MoE (Mezcla de Expertos) con 5.1B y 3.6B parámetros activos.

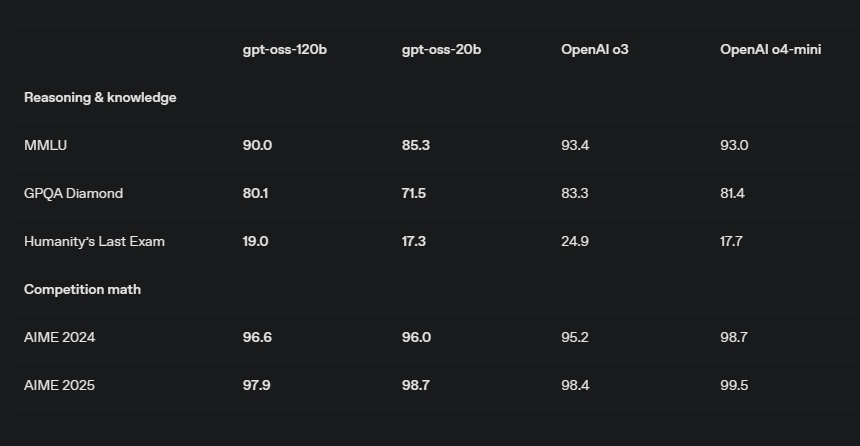

El modelo de IA gpt-oss-120b logra un rendimiento similar al o4-mini, y el modelo más pequeño gpt-oss-20b es comparable al o3-mini. En su publicación de blog, OpenAI escribe: "Fueron entrenados usando una mezcla de aprendizaje por refuerzo y técnicas informadas por los modelos internos más avanzados de OpenAI, incluyendo o3 y otros sistemas fronterizos."

Los usuarios y desarrolladores pueden ejecutar el modelo de IA gpt-oss-120b localmente en una sola GPU con 80 GB de VRAM. Y el modelo más pequeño gpt-oss-20b puede ejecutarse en portátiles y teléfonos inteligentes con solo 16 GB de memoria. Además, estos nuevos modelos de OpenAI tienen una longitud de contexto de 128k tokens.

También lee:

Cómo instalar y ejecutar LLMs localmente en teléfonos Android

OpenAI dice que estos modelos fueron entrenados principalmente en un conjunto de datos en inglés, y sobresalen en STEM, programación y conocimiento general. Lo que es interesante es que ambos modelos de pesos abiertos admiten flujos de trabajo agentes, incluyendo el uso de herramientas como búsqueda web y ejecución de código Python. Significa que puedes usar estos modelos localmente para completar tareas en tu computadora sin requerir una conexión a internet.

Hablando de benchmarks, el modelo más grande gpt-oss-120b casi iguala al modelo insignia o3 de OpenAI en Codeforces. En el desafiante benchmark Humanity’s Last Exam, gpt-oss-120b obtiene un 19% y o3 logra un 24.9% con acceso a herramientas. Luego, en GPQA Diamond, gpt-oss-120b obtuvo un 80.1% mientras que o3 puntuó 83.3%.

Mirando los benchmarks, los modelos de pesos abiertos de OpenAI parecen potentes. Sería interesante ver qué tan bien se desempeñan gpt-oss-120b y gpt-oss-20b frente a modelos de IA de pesos abiertos chinos como Qwen y DeepSeek. Ambos modelos se lanzan bajo la licencia Apache 2.0 y se pueden descargar desde Hugging Face (120b | 20b).

Si quieres probar el modelo de IA más pequeño gpt-oss-20b en tu PC, puedes instalar Ollama y ejecutar ollama run gpt-oss:20b para comenzar de inmediato. Estos modelos también están disponibles en LM Studio.

Si cree que algún contenido infringe derechos de autor o propiedad intelectual, contacte en bitelchux@yahoo.es.

Copyright notice

If you believe any content infringes copyright or intellectual property rights, please contact bitelchux@yahoo.es.